Здравствуйте!

Новичков часто пугает аббревиатура SEO. Если кратко SEO — это комплекс действий для продвижения сайта в поисковиках. Но что именно понимать под продвижением, какие методы работают, а какие уже устарели, остается вопросом.

В статье объясним простыми словами, что такое SEO, когда появился термин, как развивалась SEO-оптимизация.

В статье объясним простыми словами, что такое SEO, когда появился термин, как развивалась SEO-оптимизация.

И ответим на главный вопрос новичков — сложно ли разобраться в SEO и научиться продвигать сайты самостоятельно. Или нужно обязательно обращаться к SEO-специалистам и тратить огромные деньги.

Что такое SEO: расшифровка термина, история появления и развития

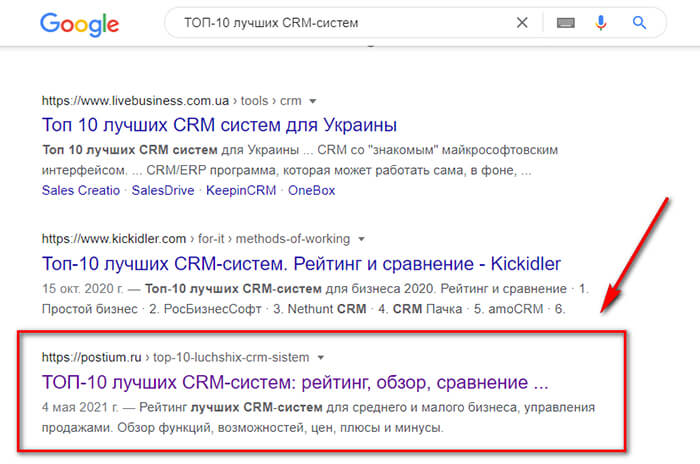

SEO (от английского Search Engine Optimization) — это оптимизация сайта под поисковые системы. Когда человек вводит запрос в поиске например, «ТОП-10 лучших CRM-систем», поисковая система выдает перечень страниц с разными сайтами, которые могут отвечать данному запросу. Это сотни страниц выдачи, но каждый владелец сайта хочет попасть на первую и желательно повыше (в идеале в ТОП-3).

SEO (от английского Search Engine Optimization) — это оптимизация сайта под поисковые системы. Когда человек вводит запрос в поиске например, «ТОП-10 лучших CRM-систем», поисковая система выдает перечень страниц с разными сайтами, которые могут отвечать данному запросу. Это сотни страниц выдачи, но каждый владелец сайта хочет попасть на первую и желательно повыше (в идеале в ТОП-3).

Чтобы попасть в ТОП владельцы сайтов приложили немало действий — добавили качественный контент на страницу, добавили релевантные ключевики, правильно прописали Title и Description, проработали юзабилити сайтов и это не все.

То есть, SEO — это комплекс действий, направленный на то, чтобы сделать сайт более привлекательным для поисковиков и посетителей. Последние важны с точки зрения поведенческих факторов — то, как пользователи ведут себя на сайте влияет на его отображение в поисковиках. Если люди проводят много времени на сайте, переходят на разные страницы, возвращаются на ресурс позже — это хорошо для продвижения.

То есть, SEO — это комплекс действий, направленный на то, чтобы сделать сайт более привлекательным для поисковиков и посетителей. Последние важны с точки зрения поведенческих факторов — то, как пользователи ведут себя на сайте влияет на его отображение в поисковиках. Если люди проводят много времени на сайте, переходят на разные страницы, возвращаются на ресурс позже — это хорошо для продвижения.

Важно: стоит понимать, что все сайты не могут быть в ТОПе. И даже попав на верхние строчки, страница не может находиться там вечно. Можно говорить о ежедневной конкуренции сайтов за высокую строчку в поиске по тому или иному запросу. Чтобы не терять позиции, нужно регулярно заниматься SEO-продвижением и работой над сайтом.

P.S. Говоря о SEO, стоит упомянуть, что этот термин касается не только сайтов. Например, есть SEO-оптимизация видео на YouTube. То есть, это касается любого контента, который можно продвигать через поиск, включая поиск внутри платформы с этим контентом.

Когда и как появился термин SEO

С 1991 по 1993 годы никакого SEO не было. Тогда нужно было вручную вводить адрес сайта в поисковом окне, чтобы открыть его и найти необходимую информацию.

1993 по 1996 год было создано несколько простых поисковиков: Yahoo, JumpStation, WebCrawler, Lycos, Altavista, Excite, AskJeeves, Inktomi, Magellan. Можно сказать, что в те годы SEO только-только зарождалось, но принцип поиска все еще был примитивным.

1993 по 1996 год было создано несколько простых поисковиков: Yahoo, JumpStation, WebCrawler, Lycos, Altavista, Excite, AskJeeves, Inktomi, Magellan. Можно сказать, что в те годы SEO только-только зарождалось, но принцип поиска все еще был примитивным.

Например, JumpStation использовал поискового робота и содержал форму для ввода запросов, но искал страницы только по заголовкам. WebCrawler кроме заголовков умел «выцеплять» слова из страниц.

Соответственно, владельцам сайтов нужно было составлять заголовки и текст с учетом того, как информацию будут искать в поиске. Но все же говорить о полноценной SEO-оптимизации было рано.

В 1993 году появился Яндекс, но тогда это была программа, которая искала файлы на компьютере. Разработчики создали отдельный словарь ключевиков на русском языке (можно сказать, прототип Яндекс.Вордстата). Но тогда Яндекс еще не работал в вебе.

В 1993 году появился Яндекс, но тогда это была программа, которая искала файлы на компьютере. Разработчики создали отдельный словарь ключевиков на русском языке (можно сказать, прототип Яндекс.Вордстата). Но тогда Яндекс еще не работал в вебе.

Как поисковая система Яндекс был анонсирован в 1997 году, тогда же поисковик BackRub (появился в 1996 году) был переименован в Google.

То есть, 2 самых популярных на сегодняшний день поисковика полноценно (для того времени) заработали в 1997 году. Этот же год можно считать началом появления того SEO-продвижения, которое мы знаем.

Считается, что основоположником термина SEO стал американский журналист, технолог и предприниматель Дэнни Салливан. Он заметил закономерности в работе поисковых систем и в 1996 (до анонса Яндекса и Гугла) опубликовал исследование под названием «Руководство для веб-мастеров по поисковым системам». В 1997 Салливан начал вести сайт Search Engine Watch с советами для вебмастеров, как добиться хороших результатов в поиске.

История развития поисковой оптимизации

Зачем знать, как менялись принципы SEO-продвижения? Все просто — чтобы не совершать ошибок. Некоторые владельцы сайтов и даже «специалисты» пользуются устаревшими методиками. Это не только не помогает сайту, но и может навредить.

Хронология развития SEO:

Хронология развития SEO:

1997 год. Первое время после официального запуска Яндекс и Google при ранжировании сайтов опирались на 3 ключевых момента:

- Title — название страницы.

- Description — описание страницы (поисковик понимал, о чем она)

- Ключевые слова — поисковик считал, сколько раз ключевые слова встречаются в тексте, чтобы понять, что содержимое текста соответствует запросу.

Примерно в то же время появилось «черное SEO» — примитивные технологии, суть которых сводилась к тому, чтобы занять высокие места в поиске без учета интересов пользователей. Они выводили сайты на высокие позиции, но были бесполезными для читателей.

В итоге появились такие явления, как:

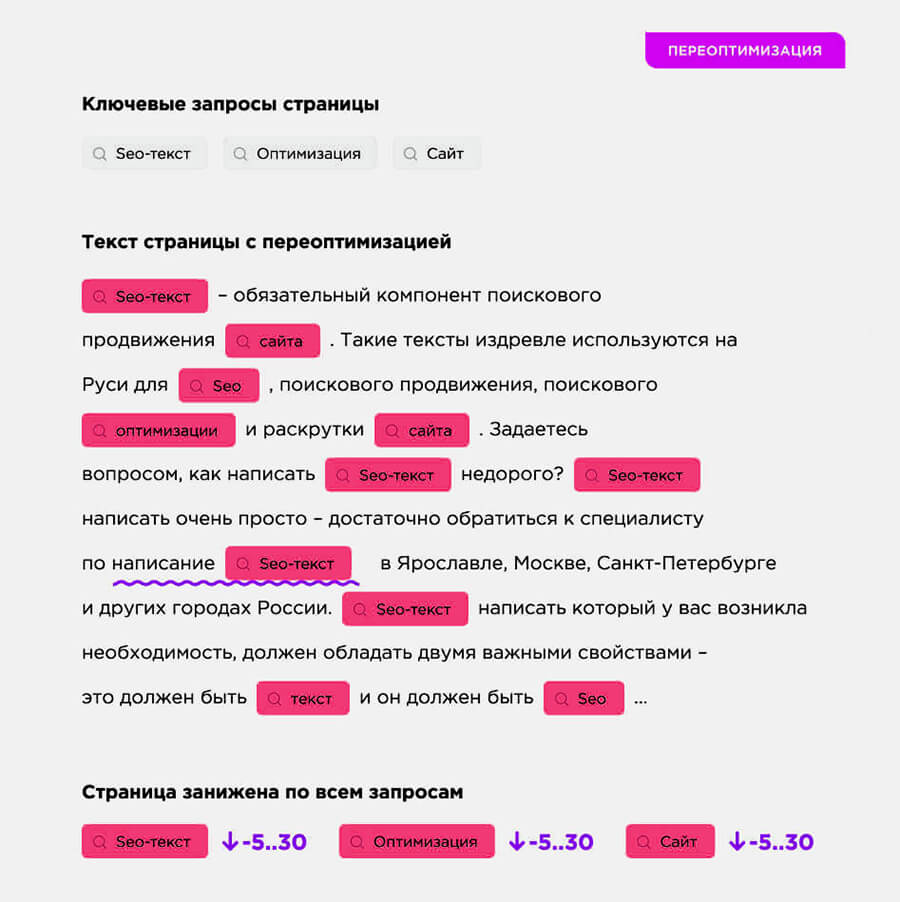

1. Переспам. Тексты, в которые запихивали как можно больше ключевых слов. Читать их было невозможно, сайты не решали проблемы пользователей, но зато хорошо распознавались поисковиками.

Типичный пример такого текста:

Типичный пример такого текста:

*Чтобы не шокировать пользователей большим количеством ключевиков, некоторые вебмастера писали их белым текстом на белом фоне, чтобы ключи все равно распознавались поисковиками.

2. Дорвеи. Ресурсы, созданные с целью автоматического перенаправления посетителей на другие сайты.

3. Клоакинг. Реальное содержимое страницы отличается от информации, которую получил поисковик.

Важно: сейчас эти способы продвижения не работают, и их использование может отправить ваш сайт под фильтры поисковиков.

С этого момента началась многолетняя борьба поисковиков с черными SEO-методами. Поисковики совершенствовались и улучшали свои алгоритмы ранжирования, что меняло подход к SEO.

1998 год. Google запускает алгоритм PageRank. Теперь он оценивает не только релевантность запроса содержанию текста, но и ссылки на этот сайт на других ресурсах (количество внешних ссылок).

Это привело к другой крайности — вебмастера стали массово скупать ссылки. И к спаму ключевиками прибавился ссылочный спам.

Это привело к другой крайности — вебмастера стали массово скупать ссылки. И к спаму ключевиками прибавился ссылочный спам.

До 2000 года алгоритмы немного менялись, но в приоритете все равно оставались ключи и внешние ссылки. Менялось требование к плотности ключевиков, сайтам-донорам и объему текста.

В 2003 году у Google появился алгоритм Cassandra, который начал пессимизировать (понижать в выдаче) сайты со скрытыми ключевиками. В том же году появился алгоритм Florida, который пессимизировал сайты с неуникальным контентом и заспамленные ссылками.

В 2004 году появился алгоритм Austin, который еще жестче наказывал за переспам и скрытый контент.

То есть, в 2003-2004 SEO-специалистам пришлось пересмотреть способы оптимизации — ключевики стали использовать аккуратнее, скрытые ключевики убрали совсем, копирайтеры стали писать более уникальные тексты.

В 2004 году Google запускает алгоритм Brandy, который учится понимать синонимы, а в 2006 запускает изменение на основе алгоритма Orion (поисковик начинает понимать смежные по тематике запросы и предлагать их в результате выдачи).

В 2004 году Google запускает алгоритм Brandy, который учится понимать синонимы, а в 2006 запускает изменение на основе алгоритма Orion (поисковик начинает понимать смежные по тематике запросы и предлагать их в результате выдачи).

Это не сильно повлияло на действия по оптимизации, но данные алгоритмы стали предпосылками к появлению LSI.

2008 год. Яндекс опирался на количество ключевиков и внешние ссылки дольше, чем Google. Но в 2008 год появился алгоритм «Магадан», который стал учитывать транслитерацию, перевод слов и аббревиатуры. Вторая версия «Магадана» сделала уникальность текста одним из ключевым фактором ранжирования.

SEO-специалисты начали делать упор на уникальность текста. Ключевики все также играли важную роль.

SEO-специалисты начали делать упор на уникальность текста. Ключевики все также играли важную роль.

После «Магадана» появился алгоритм Яндекса «Находка», который стал различать запросы во множественном и единственном числе, а также понимать различие между слитным и раздельным написанием слов.

В плане SEO это повлияло на более точный подбор ключевых слов при составлении семантического ядра.

Оставалась другая проблема — копирайтеры писали очень длинные тексты, чтобы там было много ключевиков, но при этом текст был написан больше для людей, а не поисковиков.

С 2010 года Яндекс стал понижать в выдаче страницы со слишком длинными текстами.

Для SEO это означало переход от «портянок» текста с 20-30 ключевиками к менее объемным, но более структурированным текстам.

В 2011 году Google запускает алгоритм Panda, который начал оценивать сайты не только по текстовому наполнению и ключевикам, но и по взаимодействию пользователей с сайтом (по поведенческим факторам). Он начал определять степень вовлеченности, время визита, глубину просмотра, процент отказов, процент возвратов на сайт. Яндекс в этом же году запустил алгоритм «Ты спамный», который понижал в выдаче сайты с большим количеством ключевиков и тегом strong.

Для SEO и копирайтинга это стало началом создания полезного информативного контента вместо текстов, единственной ценностью которых было правильно распределенное количество ключевиков.

Для SEO и копирайтинга это стало началом создания полезного информативного контента вместо текстов, единственной ценностью которых было правильно распределенное количество ключевиков.

В 2012 году Google запускает алгоритм DMCA (Digital Millennium Copyright Act), который еще более жестко пессимизировал сайты с ворованным контентом.

Надо сказать, черное SEO несколько лет побеждало — еще в 2008-2010 годах количество ключевиков и внешних ссылок было важнее качества текста.

Выдача в поисковиках стала более качественной где-то с 2015-2016 годов. В 2015 у Яндекса появился алгоритм «Минусинск». Он начал более жестко отслеживать переоптимизированные ключевиками тексты, некачественные внешние ссылки и злоупотреблением покупок ссылок.

На SEO это повлияло в плане создания более качественных текстов и более тщательного продвижения ссылками. Теперь нужно было искать качественные сайты-доноры (а не размещаться где попало), наращивать ссылочную массу постепенно, упор делался на естественные ссылки (то есть, стало иметь значение качество текста с ссылкой, тематика сайта, количество ссылок в тексте, околоссылочный текст).

В 2016 году Google подключил к своему алгоритму систему RankBrain, который умел понимать смысл всего контента, а не отдельных слов и мог самообучаться. Яндекс запустил аналогичный алгоритм «Палех».

В 2016 году Google подключил к своему алгоритму систему RankBrain, который умел понимать смысл всего контента, а не отдельных слов и мог самообучаться. Яндекс запустил аналогичный алгоритм «Палех».

Выдача стала более тонко соответствовать запросам пользователя исходя из содержимого страницы, а не только ключевиков. Это заставило SEO и копирайтинг еще больше уйти в сторону качества информации, изложенной в текстах.

В 2017 году Яндекс запустил алгоритм «Баден-Баден». Он еще жестче пессимизировал сайты за переспам и неестественные речевые обороты. В этом же году Яндекс выпустил алгоритм «Королев», который формировал выдачу, анализируя все содержание страницы и изображений.

Копирайтеры вздохнули с облегчением. Теперь можно было писать более «человечные» тексты и постепенно отходить от точного вхождения многословных ключей вроде «Зайдя в раздел «Обувь», вы сможете купить недорогие мужские ботинки в интернет-магазине «Подкова» с доставкой в Екатеринбурге».

SEO сегодня

Поисковики не раскрывают все нюансы своих алгоритмов (тем более, в них постоянно происходят изменения).

Можно сказать поисковые системы учитывают следующие факторы при ранжировании:

Можно сказать поисковые системы учитывают следующие факторы при ранжировании:

- коммерческие факторы — факторы, которые влияют на решение посетителя совершить покупку на сайте. Касается сайтов, которые продают товары и услуги и продвигаются по коммерческим запросам (в основном это интернет-магазины). Есть несколько десятков факторов, которые можно отнести к коммерческим, например, дизайн сайта, информация о компании, работающая кнопка «Купить» в карточке товаров, наличие отзывов. Сайт и сама компания должны вызывать доверие у пользователей. Также важно, чтобы все элементы интернет-магазина правильно функционировали. Например, если клиент положил товар в корзину, но не может оформить и оплатить заказ из-за технической ошибки — это минус для продвижения.

- ymyl и E‑A-T. Термином YMYL (от англ. «Your Money or Your Life» — «Твои деньги или твоя жизнь») в Google обозначают сайты, информация на которых напрямую влияет на жизнь, здоровье, финансы, социальную жизнь человека. Примером служат медицинские сайты, новостные порталы, юридические ресурсы, сайты органов власти. У поисковиков повышенные требования к контенту на таких ресурсах. Для оценки их контента алгоритмы учитывают E-A-T факторы.

Что это означает, если кратко:

Что это означает, если кратко:

Е — Expertise (экспертиза, компетентность) — насколько экспертная изложенная информация и ее автор;

А — Authoritativeness (авторитетность) — оценивается авторитетность автора и сайта;

T — Trustworthiness (надежность) — можно ли считать сайт и автора надежным источником информации.

- индекс цитирования — внешние ссылки (при этом выше уже писали, что важно количество ссылок, постепенное их наращивание, качество сайтов-доноров и качество текстов с ссылками);

- поведенческие факторы (внутренние и внешние) — это то, как взаимодействуют пользователи внутри сайта или при переходе из внешних ссылок, а также поиска. Например, если человек вводит запрос, попадает на вашу страницу и после прочтения статьи не ищет другие сайты по тому же запросу — это хорошо. Значит, он получил ответ на свой запрос на вашем сайте;

- индекс качества сайта (ИКС у Яндекса) — насколько поисковик считает ваш сайт качественным для пользователей;

- скорость загрузки сайта — для мобильных и пользователей ПК, проверяется в Google PageSpeed;

Можно ли продвигать сайты самостоятельно

Если у вас есть время и желание, то да. Но нужно немного поучиться.

Если у вас есть время и желание, то да. Но нужно немного поучиться.

Можно пройти курсы по SEO. На курсах можно освоить оптимизацию сайтов за период от 2,5 до 11 месяцев в зависимости от выбранной программы.

Заключение

Понимание, что такое SEO, помогает продвигать сайт в поисковых системах. Разобраться в SEO не так сложно, как кажется на первый взгляд. Но нужно учитывать, что алгоритмы поисковиков постоянно меняются, а с ними меняется и подход к продвижению. Это можно было заметить по истории развития SEO. Научившись тонкостям оптимизации, вы сможете продвигать свои сайты и сайты заказчиков.

До новых встреч!