Добрый день, дорогие друзья!

Все вы знаете, что поисковая оптимизация – дело ответственное и тонкое. Нужно учитывать абсолютно каждую мелочь, чтобы получить приемлемый результат.

Сегодня мы поговорим о robots.txt – файле, который знаком каждому вебмастеру. Именно в нем прописываются все самые основные инструкции для поисковых роботов.

Сегодня мы поговорим о robots.txt – файле, который знаком каждому вебмастеру. Именно в нем прописываются все самые основные инструкции для поисковых роботов.

Как правило, они с удовольствием следуют предписанным указаниям и в случае неправильного составления отказываются от индексации веб-ресурса.

Далее мы расскажем вам о том, как составлять правильный вариант robots.txt, а также о том, как его настроить.

Для чего предназначен?

В предисловии мы уже описали, что это такое. Теперь расскажем, зачем он нужен.

Robots.txt – небольшой текстовой файл, который хранится в корне сайта. Он используется поисковыми системами. В нем четко прописаны правила индексации, т. е. какие разделы сайта нужно индексировать (добавлять в поиск), а какие – нет.

Обычно от индексации закрываются технические разделы сайта. Изредка в черный список попадают неуникальные страницы (копипаст политики конфиденциальности тому пример). Здесь же “роботам объясняются” принципы работы с разделами, которые нужно индексировать. Очень часто прописывают правила для нескольких роботов отдельно. Об этом мы и поговорим далее.

При правильной настройке robots.txt ваш сайт гарантированно вырастет в позициях поисковых систем. Роботы будут учитывать только полезный контент, обделяя вниманием дублированные или технические разделы.

Создание robots.txt

Чтобы создать файл, достаточно воспользоваться стандартным функционалом вашей операционной системы, после чего выгрузить его на сервер через FTP. Где он лежит (на сервере) догадаться несложно – в корне. Обычно эта папка называется public_html.

Вы без труда сможете попасть в нее с помощью любого FTP-клиента (например, FileZilla) или встроенного файлового менеджера. Естественно, мы не будем загружать на сервер пустой роботс.

Впишем туда несколько основных директив (правил):

Впишем туда несколько основных директив (правил):

User-agent: *

Allow: /

Используя эти строки в своем файле robots, вы обратитесь ко всем роботам (директива User-agent), позволив им индексировать ваш сайт всецело и полностью (включая все тех. страницы Allow: /)

Конечно же, такой вариант нам не особо подходит. Файл будет не особо полезен для оптимизации под поисковики. Он определенно нуждается в грамотной настройке. Но перед этим мы рассмотрим все основные директивы и значения robots.txt.

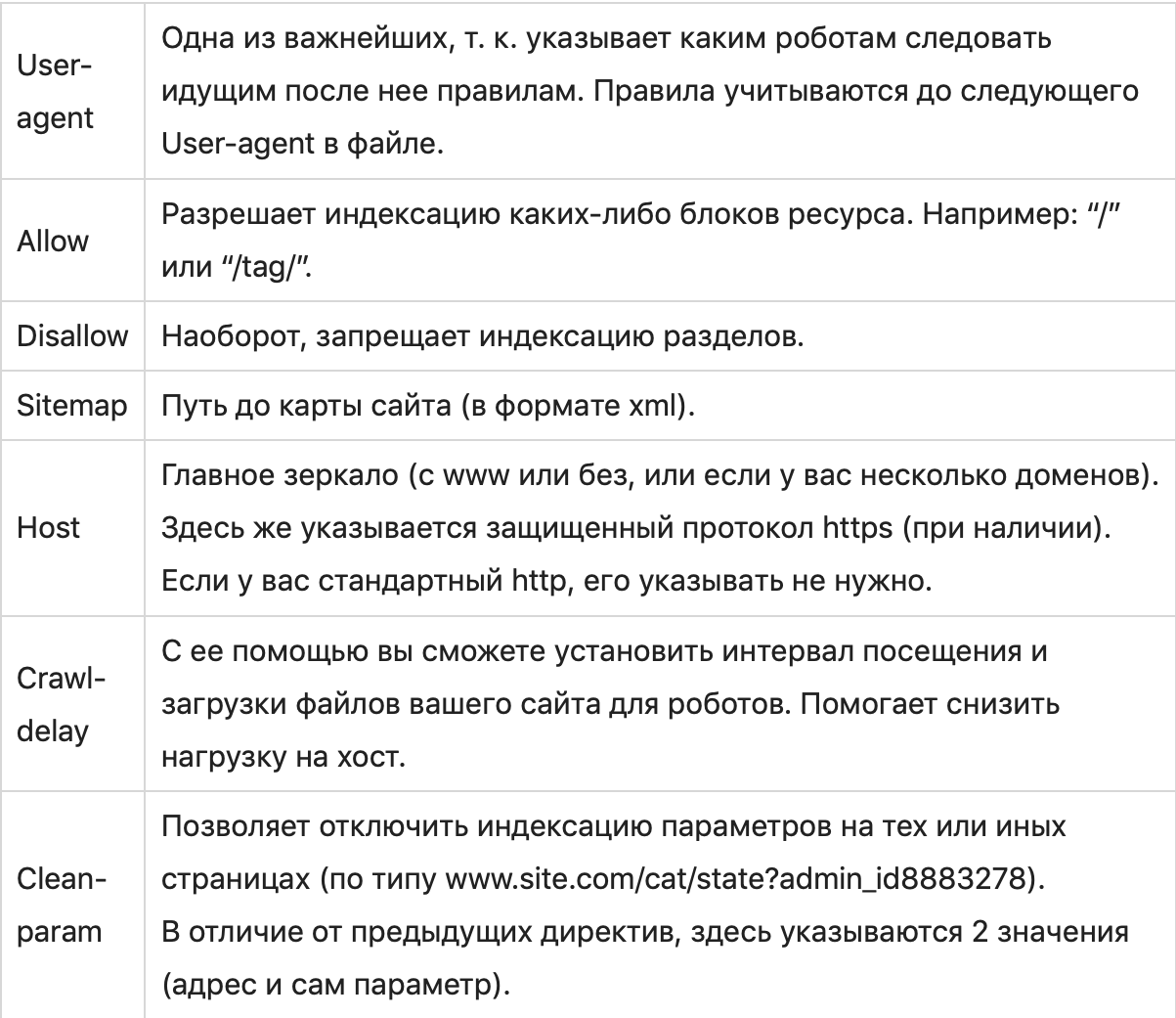

Директивы

Это все правила, которые поддерживаются флагманскими поисковиками. Именно с их помощью мы будем создавать наш роботс, оперируя различными вариациями для самых разных видов сайтов.

Настройка

Для грамотной настройки файла роботов нам нужно точно знать, какие из разделов сайта должны быть проиндексированы, а какие – нет.

В случае с простым одностраничником на html + css нам достаточно прописать несколько основных директив, таких как:

User-agent: *

Allow: /

Sitemap: site.ru/sitemap.xml

Host: www.site.ru

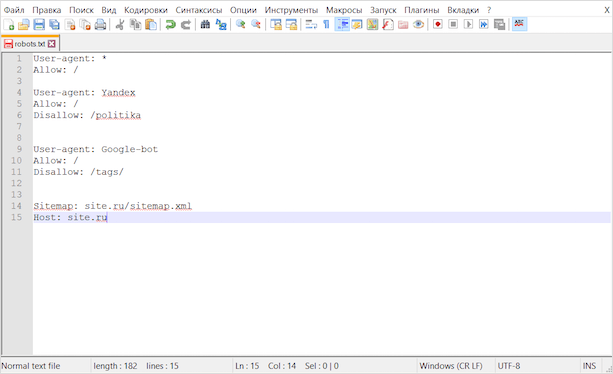

Здесь мы указали правила и значения для всех поисковых систем. Но лучше добавить отдельные директивы для Гугла и Яндекса.

Выглядеть это будет так:

Выглядеть это будет так:

User-agent: *

Allow: /

User-agent: Yandex

Allow: /

Disallow: /politika

User-agent: GoogleBot

Allow: /

Disallow: /tags/

Sitemap: site.ru/sitemap.xml

Host: site.ru

Теперь на нашем html-сайте будут индексироваться абсолютно все файлы. Если мы хотим исключить какую-то страницу или картинку, то нам необходимо указать относительную ссылку на этот фрагмент в Disallow.

Вы можете использовать сервисы автоматической генерации файлов роботс. Не гарантирую, что с их помощью вы создадите идеально правильный вариант, но в качестве ознакомления можно попробовать.

Среди таких сервисов можно выделить:

С их помощью вы сможете создать robots.txt в автоматическом режиме. Лично мы крайне не рекомендуем этот вариант, потому как намного проще сделать это вручную, настроив под свою платформу.

Говоря о платформах, мы имеем ввиду всевозможные CMS, фреймворки, SaaS-системы и многое другое. Далее мы поговорим о том, как настраивать файл роботов WordPress и Joomla.

Но перед этим выделим несколько универсальных правил, которыми можно будет руководствоваться при создании и настройке роботс почти для любого сайта:

Закрываем от индексирования (Disallow):

Закрываем от индексирования (Disallow):

- админку сайта;

- личный кабинет и страницы регистрации/авторизации;

- корзину, данные с форм заказов (для интернет-магазина);

- папку cgi (располагается на хосте);

- служебные разделы;

- скрипты ajax и json;

- UTM и Openstat-метки;

- различные параметры.

Открываем (Allow):

- картинки;

- JS и CSS-файлы;

- прочие элементы, которые должны учитываться поисковыми системами.

Помимо этого, в конце не забываем указать данные sitemap (путь к карте сайта) и host (главное зеркало).

Robots.txt для WordPress

Для создания файла нам нужно точно так же забросить robots.txt в корень сайта. Изменять его содержимое в таком случае можно будет с помощью все тех же FTP и файловых менеджеров.

Для создания файла нам нужно точно так же забросить robots.txt в корень сайта. Изменять его содержимое в таком случае можно будет с помощью все тех же FTP и файловых менеджеров.

Есть и более удобный вариант – создать файл с помощью плагинов. В частности, такая функция есть у Yoast SEO. Править роботс прямо из админки куда удобнее.

Как вы решите создать этот файл – дело ваше, нам важнее понять, какие именно директивы там должны быть.

На наших сайтах под управлением WordPress используем такой вариант:

На наших сайтах под управлением WordPress используем такой вариант:

User-agent: * # правила для всех роботов, за исключением Гугла и Яндекса

Disallow: /cgi-bin # папка со скриптами

Disallow: /? # параметры запросов с домашней страницы

Disallow: /wp- # файлы самой CSM (с приставкой wp-)

Disallow: *?s= # \

Disallow: *&s= # все, что связано с поиском

Disallow: /search/ # /

Disallow: /author/ # архивы авторов

Disallow: /users/ # и пользователей

Disallow: */trackback # уведомления от WP о том, что на вас кто-то ссылается

Disallow: */feed # фид в xml

Disallow: */rss # и rss

Disallow: */embed # встроенные элементы

Disallow: /xmlrpc.php # WordPress API

Disallow: *utm= # UTM-метки

Disallow: *openstat= # Openstat-метки

Disallow: /tag/ # тэги (при наличии)

Allow: */uploads # открываем загрузки (картинки и т. д.)

User-agent: GoogleBot # для Гугла

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: *utm=

Disallow: *openstat=

Disallow: /tag/

Allow: */uploads

Allow: /*/*.js # открываем JS-файлы

Allow: /*/*.css # и CSS

Allow: /wp-*.png # и картинки в формате png

Allow: /wp-*.jpg # \

Allow: /wp-*.jpeg # и в других форматах

Allow: /wp-*.gif # /

Allow: /wp-admin/admin-ajax.php # работает вместе с плагинами

User-agent: Yandex # для Яндекса

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: /xmlrpc.php

Disallow: /tag/

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # чистим UTM-метки

Clean-Param: openstat # и про Openstat не забываем

Sitemap: # прописываем путь до карты сайта

Host: https://site.ru # главное зеркало

Внимание! При копировании строк в файл – не забудьте удалить все комментарии (текст после #).

Внимание! При копировании строк в файл – не забудьте удалить все комментарии (текст после #).

Такой вариант robots.txt наиболее популярен среди вебмастеров, которые используют WP. Идеальный ли он? Нет. Вы можете попытаться что-то добавить или наоборот убрать. Но учтите, что при оптимизации текстовика роботов нередки ошибки. О них мы поговорим далее.

Robots.txt для Joomla

И хотя Joomla уже редко кто использует, мы считаем, что нельзя обделять вниманием эту замечательную CMS. Как выбрать CMS пройдите в подробный гайд. При продвижении проектов на Joomla вам непременно придется создавать файл роботс, а иначе как вы хотите закрывать от индексации ненужные элементы?

Как и в предыдущем случае, вы можете создать файл вручную, просто закинув его на хост, либо же использовать модуль для этих целей.

В обоих случаях вам придется его грамотно настраивать. Вот так будет выглядеть правильный вариант для Joomla:

В обоих случаях вам придется его грамотно настраивать. Вот так будет выглядеть правильный вариант для Joomla:

User-agent: *

Allow: /*.css?*$

Allow: /*.js?*$

Allow: /*.jpg?*$

Allow: /*.png?*$

Disallow: /cache/

Disallow: /*.pdf

Disallow: /administrator/

Disallow: /installation/

Disallow: /cli/

Disallow: /libraries/

Disallow: /language/

Disallow: /components/

Disallow: /modules/

Disallow: /includes/

Disallow: /bin/

Disallow: /component/

Disallow: /tmp/

Disallow: /index.php

Disallow: /plugins/

Disallow: /*mailto/

Disallow: /logs/

Disallow: /component/tags*

Disallow: /*%

Disallow: /layouts/

User-agent: Yandex

Disallow: /cache/

Disallow: /*.pdf

Disallow: /administrator/

Disallow: /installation/

Disallow: /cli/

Disallow: /libraries/

Disallow: /language/

Disallow: /components/

Disallow: /modules/

Disallow: /includes/

Disallow: /bin/

Disallow: /component/

Disallow: /tmp/

Disallow: /index.php

Disallow: /plugins/

Disallow: /*mailto/

Disallow: /logs/

Disallow: /component/tags*

Disallow: /*%

Disallow: /layouts/

User-agent: GoogleBot

Disallow: /cache/

Disallow: /*.pdf

Disallow: /administrator/

Disallow: /installation/

Disallow: /cli/

Disallow: /libraries/

Disallow: /language/

Disallow: /components/

Disallow: /modules/

Disallow: /includes/

Disallow: /bin/

Disallow: /component/

Disallow: /tmp/

Disallow: /index.php

Disallow: /plugins/

Disallow: /*mailto/

Disallow: /logs/

Disallow: /component/tags*

Disallow: /*%

Disallow: /layouts/

Host: site.ru # не забудьте здесь поменять адрес на свой

Sitemap: site.ru/sitemap.xml # и здесь

Как правило, этого достаточно, чтобы лишние файлы не попадали в индекс.

Ошибки при настройке

Очень часто люди допускают ошибки при создании и настройке файла роботс.

Вот самые часто встречающиеся из них:

Вот самые часто встречающиеся из них:

- Правила указаны только для User-agent.

- Отсутствуют Host и Sitemap.

- Наличие http-протокола в директиве Host (нужно указывать лишь https).

- Несоблюдение правил вложенности при открытии/закрытии картинок.

- Не закрыты UTM и Openstat-метки.

- Прописывание директив host и sitemap для каждого робота.

- Поверхностная проработка файла.

Очень важно правильно настроить этот маленький файлик.

Очень важно правильно настроить этот маленький файлик.

При допущении грубых ошибок вы можете потерять значительную часть трафика, поэтому будьте предельно внимательны при настройке.

Как проверить файл?

Для этих целей лучше использовать специальные сервисы от Yandex и Google, т. к. эти поисковые системы являются наиболее популярными и востребованными (чаще всего единственно используемыми), такие поисковики как Bing, Yahoo или Rambler рассматривать нет смысла.

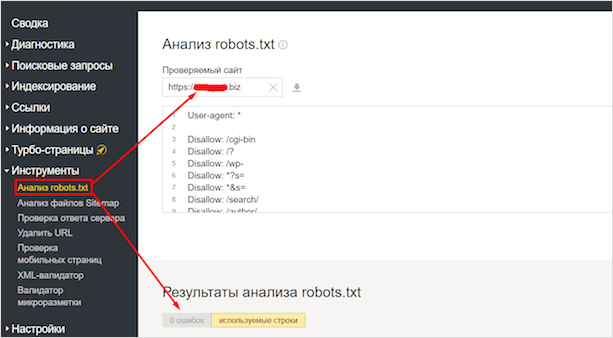

Для начала рассмотрим вариант с Яндексом. Заходим в Вебмастер. После чего в Инструменты – Анализ robots.txt.

Здесь вы сможете проверить файл на ошибки, а также проверить в реальном времени, какие страницы открыты для индексации, а какие – нет. Весьма удобно.

У Гугла есть точно такой же сервис. Идем в Search Console. Находим вкладку Сканирование, выбираем – Инструмент проверки файла robots.txt.

Здесь точно такие же функции, как и в отечественном сервисе.

Обратите внимание, что он показывает нам 2 ошибки.

Связано это с тем, что Гугл не распознает директивы очистки параметров, которые мы указали для Яндекса:

- Clean-Param: utm_source&utm_medium&utm_campaign

- Clean-Param: openstat

- Обращать внимание на это не стоит, т. к. роботы Google используют только правила для GoogleBot.

Заключение

Файл robots.txt очень важен для SEO-оптимизации вашего сайта. Подходите к его настройке со всей ответственностью, потому как при неправильной реализации все может пойти прахом.

Учитывайте все инструкции, которыми мы поделились в этой статье, и не забывайте, что вам не обязательно точь-в-точь копировать наши варианты роботс. Вполне возможно, что вам придется дополнительно разбираться в каждой из директив, подстраивая файл под свой конкретный случай.

До новых встреч!